📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要?

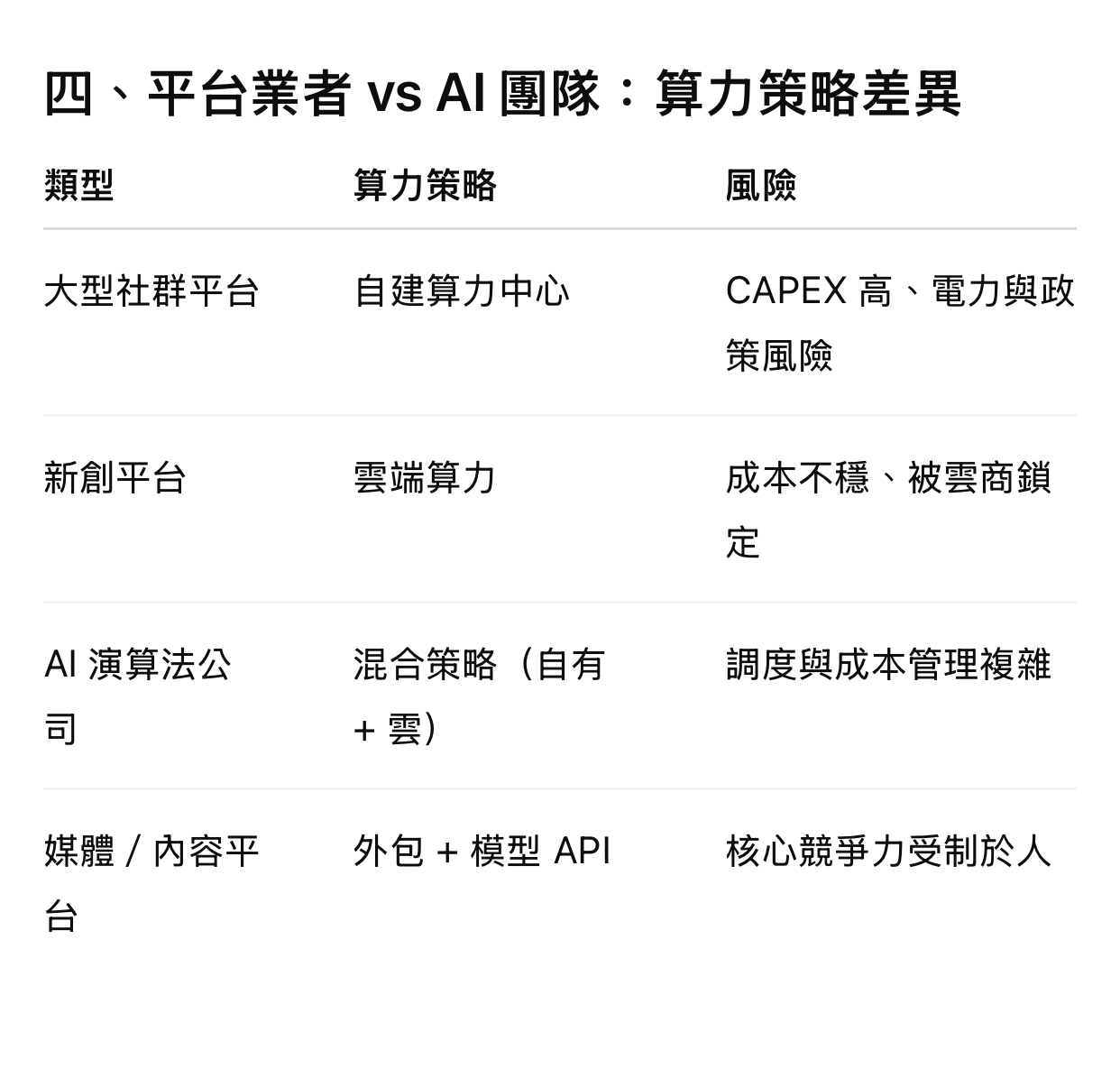

結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻

一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化

3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」👉 全部吃算力。

三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型:

• 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。

五、一句話總結(給決策者)

算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。

沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。

算力中心對於社群平台業者及AI演算法的學習模型是否重要?

結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻

一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 沒有算力中心 = 無法即時進化

3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」 全部吃算力。

三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構 • 語意與情境 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型:

• 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。

五、一句話總結(給決策者)

算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。

沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。

結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻

一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 沒有算力中心 = 無法即時進化

3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」 全部吃算力。

三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構 • 語意與情境 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型:

• 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。

五、一句話總結(給決策者)

算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。

沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。

📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要?

結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻

一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化

3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」👉 全部吃算力。

三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型:

• 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。

五、一句話總結(給決策者)

算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。

沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。