-

2025.12.12 🎁 AI新十大建設-打造主權AI 「國網雲端算力中心」啟用 : 為迎向AI時代智慧國家,行政院積極推動「AI新十大建設」方案。在國家科學及技術委員會主導下,位於臺南南部科學園區的「國網雲端算力中心」於今(12)日正式啟用,賴清德總統親臨主持,國發會主委葉俊顯、臺南市長黃偉哲、各部會、產業界、學研界代表共同見證。國網雲端算力中心兼具大型AI/HPC算力基地與國際電信節點功能,為我國推動「AI新十大建設」與「大南方新矽谷」科技戰略的重要支點,象徵臺灣在全球數位競爭中強化科技自主與算力韌性,啟動主權AI新篇章。 賴總統特別提到,臺灣不能永遠依循國外廠商訂定的系統規格,更要鼓勵臺灣的廠商發展我們自己的算力系統架構,從專用積體電路晶片,到超級電腦內部網路的設計,使用臺灣廠商研發的運算、儲存設備,以及通訊網路的交換器等,搭配臺灣的矽光子技術發展,以後能夠使用全光的網路來連結台灣的資料中心。他在典禮中宣布,國研院國網中心要和日本的 NTT 以及中華電信合作,引進下世代全光網路技術,以光通訊全面取代銅線網路,大幅降低能源消耗並提高資料傳輸速度。日本政府還特別於APEC雙邊會議中感謝臺灣協助NTT完成全光網路技術開發,同時也感謝臺灣協助 NTT 把全光網路技術引進台灣。 國科會主委吳誠文則指出,國網雲端算力中心的啟用,不僅支撐科學研究與產業應用,更具備部署未來量子電腦的戰略潛能。依據整體規劃,至2029年,國研院國網中心的算力將擴展至23MW,涵蓋南科的國網雲端算力中心與預計2029年啟用的臺南沙崙智慧創新算力中心,形成南臺灣科技廊帶的雙算力核心。此外,今日正式啟動的「臺灣算力聯盟」,顯示臺灣算力持續擴充,由政府與業界攜手建立完整的算力產業生態系,透過公私協力,打造一座真正能生產AI、部署AI、加速AI的在地工廠,為臺灣科技自主與產業創新注入強大動能。 國研院國網中心主任張朝亮表示,國網雲端算力中心具備 15MW 電量,未來預計於 2029 年啟用具備120MW電量規模的沙崙智慧創新算力中心,這兩座國家級設施不僅將支援生成式 AI 訓練、氣候模擬、生命科學、半導體研發等高階科研應用,更具備充足的電力與空間資源,可開放國內外業者進駐自建算力系統,落實公私協力,共同推動南部從製造基地邁向智慧科技重鎮。未來也將持續結合高速骨幹光纖網路,打造兼具自主韌性與國際競爭力的國家級算力基地。 國科會近年來積極推動主權AI,包括建置國家算力、訓練自主AI模型、鼓勵國人使用自己的語料庫,以及在地保存資料。由國研院國網中心建造「國網雲端算力中心」和串聯民間業者共組的「臺灣算力聯盟」,是AI新十大建設-打造主權AI關鍵的一步;加上國研院國網中心開發的生成式AI 服務平台「TAIWAN AI RAP」,可協助百工百業發展AI的各種應用。這些可讓 AI 新世代建設一步步向前推進,實現全民智慧生活圈的目標。 國網雲端算力中心的啟用,不僅為南臺灣科技走廊奠定國家級核心地位,更具體實現政府「打造人工智慧島」的願景。該中心依據「前瞻基礎建設計畫」建置,採國際商用電信中心高規格設計,具備15MW電量與高耐震、節能與備援機制,並透過高速光纖串聯南科、各大專院校與海纜登陸站,強化全台資料網路韌性,是確保國家數位韌性、資安防護以及通訊備援的關鍵堡壘;加上高規格耐震、備援供電與冷卻設計,確保遭遇災害或突發事件時服務不中斷,持續支撐國家科研與產業創新。 此外,該中心內部署由「晶創臺灣方案」支持、國內廠商合力建置、最新型的「晶創26(Nano4)」超級電腦,展現臺灣在系統整合與超級運算領域的世界級實力。賴清德總統於致詞中表示,「算力就是國力」,面對AI時代的全球競爭,臺灣不能只是硬體製造的供應者,更要成為具備自主、可信與韌性的AI科技國家。政府提出「AI新十大建設」,聚焦智慧應用、關鍵技術與數位基磐三大主軸,目標在2040年讓臺灣成為全球AI創新樞紐。此次啟用的國網雲端算力中心,是整體藍圖中最重要的關鍵環節,也代表臺灣從「矽島」邁向「人工智慧島」的堅定步伐。 在國科會發起下,「臺灣算力聯盟」也在今日正式成立。由國研院國網中心籌組,成功匯集交通部中央氣象署、友崴超級運算、超微、緯謙科技、輝達、鴻海科技集團亞灣超算等跨部會與產業夥伴,形成政府部門與民間企業共構臺灣算力生態的戰略聯盟。聯盟未來將聚焦四大核心方向:算力協調與媒合、機房與基礎資源合作、人才培育以及開源軟體推廣,攜手推動主權 AI 關鍵應用落地,強化我國算力供應鏈韌性,促進算力供應鏈與生態系加速成長,共同推動臺灣邁向新一代算力發展階段。2025.12.12

AI新十大建設-打造主權AI 「國網雲端算力中心」啟用 :

為迎向AI時代智慧國家,行政院積極推動「AI新十大建設」方案。在國家科學及技術委員會主導下,位於臺南南部科學園區的「國網雲端算力中心」於今(12)日正式啟用,賴清德總統親臨主持,國發會主委葉俊顯、臺南市長黃偉哲、各部會、產業界、學研界代表共同見證。國網雲端算力中心兼具大型AI/HPC算力基地與國際電信節點功能,為我國推動「AI新十大建設」與「大南方新矽谷」科技戰略的重要支點,象徵臺灣在全球數位競爭中強化科技自主與算力韌性,啟動主權AI新篇章。

賴總統特別提到,臺灣不能永遠依循國外廠商訂定的系統規格,更要鼓勵臺灣的廠商發展我們自己的算力系統架構,從專用積體電路晶片,到超級電腦內部網路的設計,使用臺灣廠商研發的運算、儲存設備,以及通訊網路的交換器等,搭配臺灣的矽光子技術發展,以後能夠使用全光的網路來連結台灣的資料中心。他在典禮中宣布,國研院國網中心要和日本的 NTT 以及中華電信合作,引進下世代全光網路技術,以光通訊全面取代銅線網路,大幅降低能源消耗並提高資料傳輸速度。日本政府還特別於APEC雙邊會議中感謝臺灣協助NTT完成全光網路技術開發,同時也感謝臺灣協助 NTT 把全光網路技術引進台灣。

國科會主委吳誠文則指出,國網雲端算力中心的啟用,不僅支撐科學研究與產業應用,更具備部署未來量子電腦的戰略潛能。依據整體規劃,至2029年,國研院國網中心的算力將擴展至23MW,涵蓋南科的國網雲端算力中心與預計2029年啟用的臺南沙崙智慧創新算力中心,形成南臺灣科技廊帶的雙算力核心。此外,今日正式啟動的「臺灣算力聯盟」,顯示臺灣算力持續擴充,由政府與業界攜手建立完整的算力產業生態系,透過公私協力,打造一座真正能生產AI、部署AI、加速AI的在地工廠,為臺灣科技自主與產業創新注入強大動能。

國研院國網中心主任張朝亮表示,國網雲端算力中心具備 15MW 電量,未來預計於 2029 年啟用具備120MW電量規模的沙崙智慧創新算力中心,這兩座國家級設施不僅將支援生成式 AI 訓練、氣候模擬、生命科學、半導體研發等高階科研應用,更具備充足的電力與空間資源,可開放國內外業者進駐自建算力系統,落實公私協力,共同推動南部從製造基地邁向智慧科技重鎮。未來也將持續結合高速骨幹光纖網路,打造兼具自主韌性與國際競爭力的國家級算力基地。

國科會近年來積極推動主權AI,包括建置國家算力、訓練自主AI模型、鼓勵國人使用自己的語料庫,以及在地保存資料。由國研院國網中心建造「國網雲端算力中心」和串聯民間業者共組的「臺灣算力聯盟」,是AI新十大建設-打造主權AI關鍵的一步;加上國研院國網中心開發的生成式AI 服務平台「TAIWAN AI RAP」,可協助百工百業發展AI的各種應用。這些可讓 AI 新世代建設一步步向前推進,實現全民智慧生活圈的目標。

國網雲端算力中心的啟用,不僅為南臺灣科技走廊奠定國家級核心地位,更具體實現政府「打造人工智慧島」的願景。該中心依據「前瞻基礎建設計畫」建置,採國際商用電信中心高規格設計,具備15MW電量與高耐震、節能與備援機制,並透過高速光纖串聯南科、各大專院校與海纜登陸站,強化全台資料網路韌性,是確保國家數位韌性、資安防護以及通訊備援的關鍵堡壘;加上高規格耐震、備援供電與冷卻設計,確保遭遇災害或突發事件時服務不中斷,持續支撐國家科研與產業創新。

此外,該中心內部署由「晶創臺灣方案」支持、國內廠商合力建置、最新型的「晶創26(Nano4)」超級電腦,展現臺灣在系統整合與超級運算領域的世界級實力。賴清德總統於致詞中表示,「算力就是國力」,面對AI時代的全球競爭,臺灣不能只是硬體製造的供應者,更要成為具備自主、可信與韌性的AI科技國家。政府提出「AI新十大建設」,聚焦智慧應用、關鍵技術與數位基磐三大主軸,目標在2040年讓臺灣成為全球AI創新樞紐。此次啟用的國網雲端算力中心,是整體藍圖中最重要的關鍵環節,也代表臺灣從「矽島」邁向「人工智慧島」的堅定步伐。

在國科會發起下,「臺灣算力聯盟」也在今日正式成立。由國研院國網中心籌組,成功匯集交通部中央氣象署、友崴超級運算、超微、緯謙科技、輝達、鴻海科技集團亞灣超算等跨部會與產業夥伴,形成政府部門與民間企業共構臺灣算力生態的戰略聯盟。聯盟未來將聚焦四大核心方向:算力協調與媒合、機房與基礎資源合作、人才培育以及開源軟體推廣,攜手推動主權 AI 關鍵應用落地,強化我國算力供應鏈韌性,促進算力供應鏈與生態系加速成長,共同推動臺灣邁向新一代算力發展階段。2025.12.12 🎁 AI新十大建設-打造主權AI 「國網雲端算力中心」啟用 : 為迎向AI時代智慧國家,行政院積極推動「AI新十大建設」方案。在國家科學及技術委員會主導下,位於臺南南部科學園區的「國網雲端算力中心」於今(12)日正式啟用,賴清德總統親臨主持,國發會主委葉俊顯、臺南市長黃偉哲、各部會、產業界、學研界代表共同見證。國網雲端算力中心兼具大型AI/HPC算力基地與國際電信節點功能,為我國推動「AI新十大建設」與「大南方新矽谷」科技戰略的重要支點,象徵臺灣在全球數位競爭中強化科技自主與算力韌性,啟動主權AI新篇章。 賴總統特別提到,臺灣不能永遠依循國外廠商訂定的系統規格,更要鼓勵臺灣的廠商發展我們自己的算力系統架構,從專用積體電路晶片,到超級電腦內部網路的設計,使用臺灣廠商研發的運算、儲存設備,以及通訊網路的交換器等,搭配臺灣的矽光子技術發展,以後能夠使用全光的網路來連結台灣的資料中心。他在典禮中宣布,國研院國網中心要和日本的 NTT 以及中華電信合作,引進下世代全光網路技術,以光通訊全面取代銅線網路,大幅降低能源消耗並提高資料傳輸速度。日本政府還特別於APEC雙邊會議中感謝臺灣協助NTT完成全光網路技術開發,同時也感謝臺灣協助 NTT 把全光網路技術引進台灣。 國科會主委吳誠文則指出,國網雲端算力中心的啟用,不僅支撐科學研究與產業應用,更具備部署未來量子電腦的戰略潛能。依據整體規劃,至2029年,國研院國網中心的算力將擴展至23MW,涵蓋南科的國網雲端算力中心與預計2029年啟用的臺南沙崙智慧創新算力中心,形成南臺灣科技廊帶的雙算力核心。此外,今日正式啟動的「臺灣算力聯盟」,顯示臺灣算力持續擴充,由政府與業界攜手建立完整的算力產業生態系,透過公私協力,打造一座真正能生產AI、部署AI、加速AI的在地工廠,為臺灣科技自主與產業創新注入強大動能。 國研院國網中心主任張朝亮表示,國網雲端算力中心具備 15MW 電量,未來預計於 2029 年啟用具備120MW電量規模的沙崙智慧創新算力中心,這兩座國家級設施不僅將支援生成式 AI 訓練、氣候模擬、生命科學、半導體研發等高階科研應用,更具備充足的電力與空間資源,可開放國內外業者進駐自建算力系統,落實公私協力,共同推動南部從製造基地邁向智慧科技重鎮。未來也將持續結合高速骨幹光纖網路,打造兼具自主韌性與國際競爭力的國家級算力基地。 國科會近年來積極推動主權AI,包括建置國家算力、訓練自主AI模型、鼓勵國人使用自己的語料庫,以及在地保存資料。由國研院國網中心建造「國網雲端算力中心」和串聯民間業者共組的「臺灣算力聯盟」,是AI新十大建設-打造主權AI關鍵的一步;加上國研院國網中心開發的生成式AI 服務平台「TAIWAN AI RAP」,可協助百工百業發展AI的各種應用。這些可讓 AI 新世代建設一步步向前推進,實現全民智慧生活圈的目標。 國網雲端算力中心的啟用,不僅為南臺灣科技走廊奠定國家級核心地位,更具體實現政府「打造人工智慧島」的願景。該中心依據「前瞻基礎建設計畫」建置,採國際商用電信中心高規格設計,具備15MW電量與高耐震、節能與備援機制,並透過高速光纖串聯南科、各大專院校與海纜登陸站,強化全台資料網路韌性,是確保國家數位韌性、資安防護以及通訊備援的關鍵堡壘;加上高規格耐震、備援供電與冷卻設計,確保遭遇災害或突發事件時服務不中斷,持續支撐國家科研與產業創新。 此外,該中心內部署由「晶創臺灣方案」支持、國內廠商合力建置、最新型的「晶創26(Nano4)」超級電腦,展現臺灣在系統整合與超級運算領域的世界級實力。賴清德總統於致詞中表示,「算力就是國力」,面對AI時代的全球競爭,臺灣不能只是硬體製造的供應者,更要成為具備自主、可信與韌性的AI科技國家。政府提出「AI新十大建設」,聚焦智慧應用、關鍵技術與數位基磐三大主軸,目標在2040年讓臺灣成為全球AI創新樞紐。此次啟用的國網雲端算力中心,是整體藍圖中最重要的關鍵環節,也代表臺灣從「矽島」邁向「人工智慧島」的堅定步伐。 在國科會發起下,「臺灣算力聯盟」也在今日正式成立。由國研院國網中心籌組,成功匯集交通部中央氣象署、友崴超級運算、超微、緯謙科技、輝達、鴻海科技集團亞灣超算等跨部會與產業夥伴,形成政府部門與民間企業共構臺灣算力生態的戰略聯盟。聯盟未來將聚焦四大核心方向:算力協調與媒合、機房與基礎資源合作、人才培育以及開源軟體推廣,攜手推動主權 AI 關鍵應用落地,強化我國算力供應鏈韌性,促進算力供應鏈與生態系加速成長,共同推動臺灣邁向新一代算力發展階段。· 0 Comments ·0 Shares ·720 Views ·0 Reviews2

-

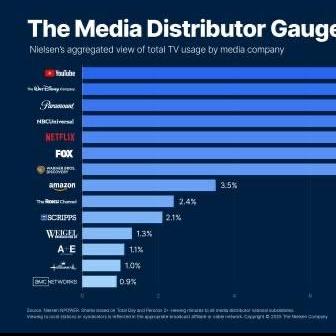

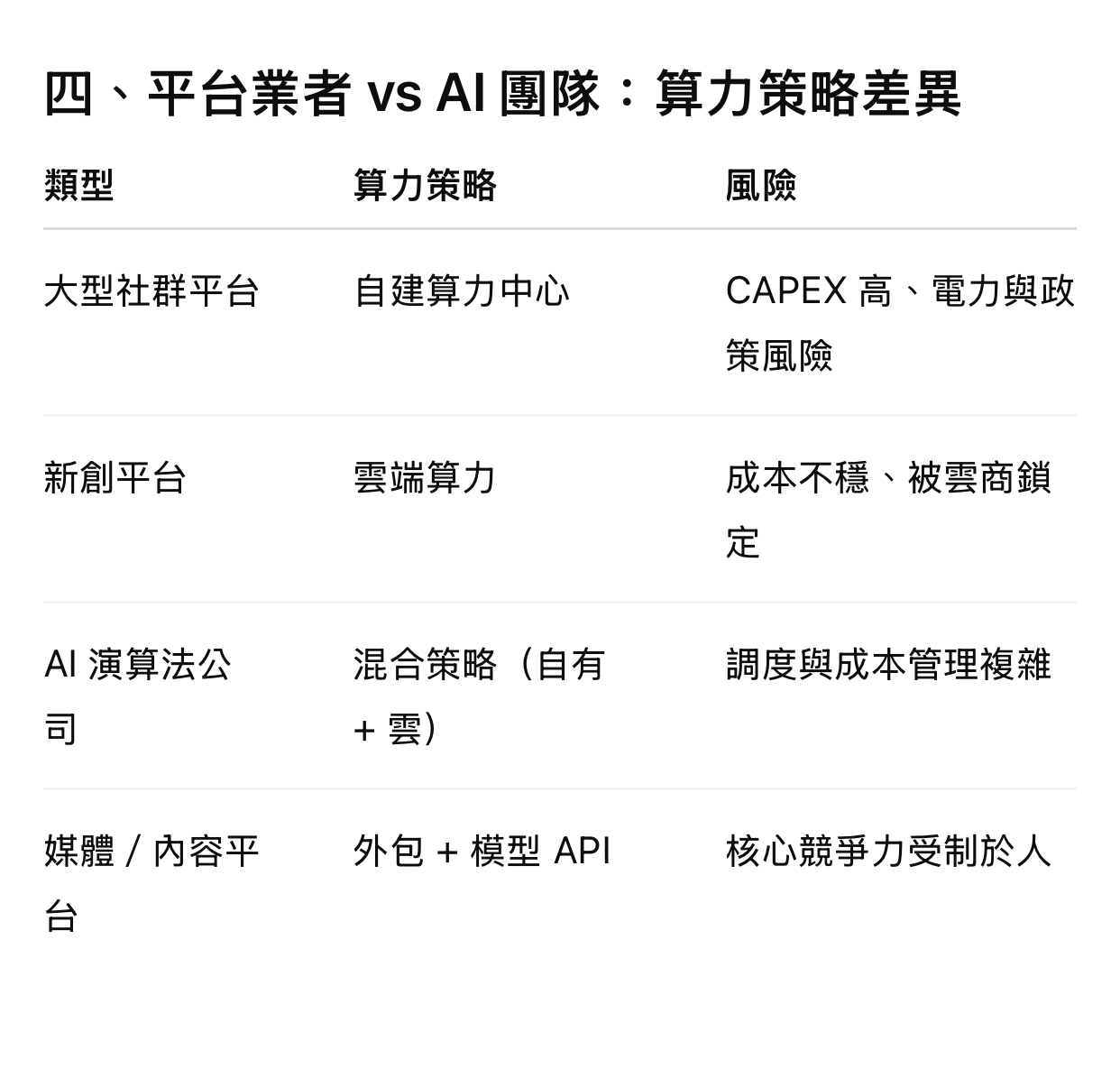

📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要? 結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻ 一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。 二、對「社群平台業者」的重要性 1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型 如果沒有足夠算力: • 模型更新頻率變慢 • 推薦精準度下降 • 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。 2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化 3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」👉 全部吃算力。 三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因: • Transformer、Diffusion、LLM 都是「可擴展模型」 • 效果隨算力呈現 scaling law 沒有算力: • 你做不出 SOTA • 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學: • 長期行為模式 • 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型: • 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。 五、一句話總結(給決策者) 算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。 沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。算力中心對於社群平台業者及AI演算法的學習模型是否重要?

結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻

一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 沒有算力中心 = 無法即時進化

3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」 全部吃算力。

三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構 • 語意與情境 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型:

• 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。

五、一句話總結(給決策者)

算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。

沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要? 結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻ 一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。 二、對「社群平台業者」的重要性 1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 這些全部都是算力密集型 如果沒有足夠算力: • 模型更新頻率變慢 • 推薦精準度下降 • 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。 2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化 3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」👉 全部吃算力。 三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因: • Transformer、Diffusion、LLM 都是「可擴展模型」 • 效果隨算力呈現 scaling law 沒有算力: • 你做不出 SOTA • 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學: • 長期行為模式 • 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型: • 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。 五、一句話總結(給決策者) 算力中心對社群平台與 AI 模型不是「IT 成本」,而是「核心生產力」。 沒有算力,就沒有學習速度;沒有學習速度,就沒有競爭力。· 0 Comments ·0 Shares ·255 Views ·0 Reviews1

-

📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要? 結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻ 一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。 ⸻ 二、對「社群平台業者」的重要性 1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 👉 這些全部都是算力密集型 如果沒有足夠算力: • 模型更新頻率變慢 • 推薦精準度下降 • 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。 ⸻ 2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化 ⸻ 3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」 👉 全部吃算力。 ⸻ 三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因: • Transformer、Diffusion、LLM 都是「可擴展模型」 • 效果隨算力呈現 scaling law 沒有算力: • 你做不出 SOTA • 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學: • 長期行為模式 • 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型: • 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。算力中心對於社群平台業者及AI演算法的學習模型是否重要?

結論先講:非常重要,而且重要性還在快速上升。

但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。

下面用「經營層能決策」的角度幫你拆解。

⸻

一、什麼是算力中心(簡化定義)

算力中心 ≈ 集中式高效能運算基礎設施

• GPU / TPU / NPU 叢集

• 高速網路(InfiniBand、RDMA)

• 大量儲存(資料湖、向量資料庫)

• 電力、散熱、容錯與資安

本質上是:把「計算能力」變成可規模化的戰略資源。

⸻

二、對「社群平台業者」的重要性

1️⃣ 推薦系統是社群平台的「命脈」

社群平台核心不是 UI,而是:

• 動態推薦(Feed / Reels / Shorts)

• 即時排序(CTR、停留時間、互動)

• 個人化模型(千人千面)

這些全部都是算力密集型

如果沒有足夠算力:

• 模型更新頻率變慢

• 推薦精準度下降

• 用戶黏著度直接受影響

Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。

⸻

2️⃣ 即時學習(Online Learning)高度依賴算力

現代社群平台不只「離線訓練」,而是:

• 即時行為回饋

• A/B 測試並行

• 模型快速迭代(小時級、甚至分鐘級)

沒有算力中心 = 無法即時進化

⸻

3️⃣ 內容審核與風控也是算力戰

• 影像辨識(暴力、裸露)

• 語意理解(仇恨、詐騙)

• Deepfake 偵測

這些模型:

• 要「大模型」

• 要「多模態」

• 要「低延遲」

全部吃算力。

⸻

三、對「AI 演算法與學習模型」的重要性

1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力

現在業界共識是:

算力已經和演算法同等重要,甚至在某些階段更重要

原因:

• Transformer、Diffusion、LLM 都是「可擴展模型」

• 效果隨算力呈現 scaling law

沒有算力:

• 你做不出 SOTA

• 你驗證不了理論

• 你只能停在小模型

⸻

2️⃣ 算力決定「你能不能學到複雜世界」

AI 不是只在學資料,而是在學:

• 長期行為模式

• 社會網絡結構

• 語意與情境

這些需要超大量樣本與參數空間

算力不足,模型「理解深度」會直接被限制。

⸻

3️⃣ 算力中心 = 研究速度的放大器

同一組資料與模型:

• 有算力中心:1 週收斂

• 沒有算力中心:3–6 個月,還可能失敗

在商業世界:慢,就是輸。

📊 算力中心對於社群平台業者及AI演算法的學習模型是否重要? 結論先講:非常重要,而且重要性還在快速上升。 但「重要的方式」會因為你是社群平台業者,還是純 AI 演算法/模型開發者而不同。 下面用「經營層能決策」的角度幫你拆解。 ⸻ 一、什麼是算力中心(簡化定義) 算力中心 ≈ 集中式高效能運算基礎設施 • GPU / TPU / NPU 叢集 • 高速網路(InfiniBand、RDMA) • 大量儲存(資料湖、向量資料庫) • 電力、散熱、容錯與資安 本質上是:把「計算能力」變成可規模化的戰略資源。 ⸻ 二、對「社群平台業者」的重要性 1️⃣ 推薦系統是社群平台的「命脈」 社群平台核心不是 UI,而是: • 動態推薦(Feed / Reels / Shorts) • 即時排序(CTR、停留時間、互動) • 個人化模型(千人千面) 👉 這些全部都是算力密集型 如果沒有足夠算力: • 模型更新頻率變慢 • 推薦精準度下降 • 用戶黏著度直接受影響 Facebook、TikTok、YouTube 的競爭,本質上是「誰的算力+模型學得快」。 ⸻ 2️⃣ 即時學習(Online Learning)高度依賴算力 現代社群平台不只「離線訓練」,而是: • 即時行為回饋 • A/B 測試並行 • 模型快速迭代(小時級、甚至分鐘級) 👉 沒有算力中心 = 無法即時進化 ⸻ 3️⃣ 內容審核與風控也是算力戰 • 影像辨識(暴力、裸露) • 語意理解(仇恨、詐騙) • Deepfake 偵測 這些模型: • 要「大模型」 • 要「多模態」 • 要「低延遲」 👉 全部吃算力。 ⸻ 三、對「AI 演算法與學習模型」的重要性 1️⃣ 模型效果 ≈ 演算法 × 資料 × 算力 現在業界共識是: 算力已經和演算法同等重要,甚至在某些階段更重要 原因: • Transformer、Diffusion、LLM 都是「可擴展模型」 • 效果隨算力呈現 scaling law 沒有算力: • 你做不出 SOTA • 你驗證不了理論 • 你只能停在小模型 ⸻ 2️⃣ 算力決定「你能不能學到複雜世界」 AI 不是只在學資料,而是在學: • 長期行為模式 • 社會網絡結構 • 語意與情境 👉 這些需要超大量樣本與參數空間 算力不足,模型「理解深度」會直接被限制。 ⸻ 3️⃣ 算力中心 = 研究速度的放大器 同一組資料與模型: • 有算力中心:1 週收斂 • 沒有算力中心:3–6 個月,還可能失敗 在商業世界:慢,就是輸。· 0 Comments ·0 Shares ·229 Views ·0 Reviews1

-

❖第一階段:顯式演算法的時代 (1950s - 1980s)** (**註:亦可稱「規則式/Rule-based」演算法時代) 這個時代的演算法典範是「人告訴電腦如何做」。 ▹核心思維 演算法就是一套由程式設計師明確定義、一步步執行的指令。人類必須完全理解問題的解法,並將其邏輯用程式碼完整地寫出來。 ▹底層技術 (a)年代/ 1940s–1960s:數值演算法 → 資料結構與排序搜尋 1970s–1980s:理論演算法(NP、隨機化、可計算性) (b)特色:演算法本身和資料結構是「核心基礎」,計算效率(時間複雜度與空間複雜度)是主要評價指標。後來延伸為不只是「怎麼算」,還涉及「是否可能算得出來」、「效率界線在哪裡」。 ▹局限性 無法應對人類難以用明確規則描述的複雜問題,例如判斷一張圖片裡是否有貓**。 (**註:其實在那時期,這問題曾試圖透過「專家系統/Expert Systems」方式,也就是「規則庫 if-else 來模擬人類推理」方式處理,不過成果十分有限。) ❖第二階段:機器學習的時代 (1980s - 2010s) 這是第一個巨大的典範轉移,思維從「告訴電腦怎麼做」轉變為「讓電腦自己學」。 ▹核心思維 演算法不再是固定的步驟。人類提供大量數據和學習目標,讓演算法自己從數據中尋找模式和規律,並建立模型來解決問題。 ▹底層技術 (a)年代/1990s–2000s:分散式與大規模資料處理(PageRank, MapReduce),以及大量統計學與傳統 ML 演算法的崛起(ex決策樹、SVM、KNN、隨機森林...etc.)。 (b)特色:處理「規模」成為主題,追求能在分散式系統上有效運行。 ▹局限性 儘管已經可以學習,但仍需要人類專家進行關鍵步驟——「特徵工程」:人類必須手動從原始數據中提取有意義的特徵,才能讓演算法學習。尤其不同專業領域就需要不同領域的專家知識,才能提取出專屬該領域的特徵、完成該領域的特徵工程。這是關鍵痛點。 ❖第三階段:深度學習的時代 (2010s - 2020s) 這是機器學習內部的一次重大典範轉移,它讓演算法從「學習」進化到「深度學習」。 ▹核心思維 這個階段解決了特徵工程的問題。透過多層神經網路(DNN),演算法能夠自動從最原始的數據中學習、並提取最抽象、最高階的特徵。意即,電腦已經開始有能力自行判斷「哪些數據是重要的」。 ▹底層技術 (a)年代/2010s–2020s:機器學習(ML)與深度學習(DL) (b)特色:不再只是「明確規則 + 決定性輸出」,而是「自我調整規則、從資料學習」。以深度學習來說,自動學習抽象特徵/表徵學習(Representation Learning),就可說是最關鍵的突破口。 ▹革命性: 這個階段讓 AI 第一次在圖像辨識、語音處理和自然語言理解等領域超越了人類的表現。 ❖總結 上述三個階段代表了演算法從「遵循規則」到「從數據中學習」,再到「自動從數據中學習特徵」的根本性演變。 (還沒完...) ❖第四階段:生成式 AI / 大模型時代(2020s-) 不是只分類或預測,不只是更深的神經網路,而是開始使模型具備跨任務、跨領域的能力,例如「生成」新的內容(語言/影像/音樂),透過Transformer 架構+海量參數+大規模語言模型(LLM),都已應用在現實生活中。 未來,方興未艾。 https://vocus.cc/article/68a712e5fd89780001b13c29 #這碗呀不大

❖第一階段:顯式演算法的時代 (1950s - 1980s)**

(**註:亦可稱「規則式/Rule-based」演算法時代)

這個時代的演算法典範是「人告訴電腦如何做」。

▹核心思維

演算法就是一套由程式設計師明確定義、一步步執行的指令。人類必須完全理解問題的解法,並將其邏輯用程式碼完整地寫出來。

▹底層技術

(a)年代/

1940s–1960s:數值演算法 → 資料結構與排序搜尋

1970s–1980s:理論演算法(NP、隨機化、可計算性)

(b)特色:演算法本身和資料結構是「核心基礎」,計算效率(時間複雜度與空間複雜度)是主要評價指標。後來延伸為不只是「怎麼算」,還涉及「是否可能算得出來」、「效率界線在哪裡」。

▹局限性

無法應對人類難以用明確規則描述的複雜問題,例如判斷一張圖片裡是否有貓**。

(**註:其實在那時期,這問題曾試圖透過「專家系統/Expert Systems」方式,也就是「規則庫 if-else 來模擬人類推理」方式處理,不過成果十分有限。)

❖第二階段:機器學習的時代 (1980s - 2010s)

這是第一個巨大的典範轉移,思維從「告訴電腦怎麼做」轉變為「讓電腦自己學」。

▹核心思維

演算法不再是固定的步驟。人類提供大量數據和學習目標,讓演算法自己從數據中尋找模式和規律,並建立模型來解決問題。

▹底層技術

(a)年代/1990s–2000s:分散式與大規模資料處理(PageRank, MapReduce),以及大量統計學與傳統 ML 演算法的崛起(ex決策樹、SVM、KNN、隨機森林...etc.)。

(b)特色:處理「規模」成為主題,追求能在分散式系統上有效運行。

▹局限性

儘管已經可以學習,但仍需要人類專家進行關鍵步驟——「特徵工程」:人類必須手動從原始數據中提取有意義的特徵,才能讓演算法學習。尤其不同專業領域就需要不同領域的專家知識,才能提取出專屬該領域的特徵、完成該領域的特徵工程。這是關鍵痛點。

❖第三階段:深度學習的時代 (2010s - 2020s)

這是機器學習內部的一次重大典範轉移,它讓演算法從「學習」進化到「深度學習」。

▹核心思維

這個階段解決了特徵工程的問題。透過多層神經網路(DNN),演算法能夠自動從最原始的數據中學習、並提取最抽象、最高階的特徵。意即,電腦已經開始有能力自行判斷「哪些數據是重要的」。

▹底層技術

(a)年代/2010s–2020s:機器學習(ML)與深度學習(DL)

(b)特色:不再只是「明確規則 + 決定性輸出」,而是「自我調整規則、從資料學習」。以深度學習來說,自動學習抽象特徵/表徵學習(Representation Learning),就可說是最關鍵的突破口。

▹革命性:

這個階段讓 AI 第一次在圖像辨識、語音處理和自然語言理解等領域超越了人類的表現。

❖總結

上述三個階段代表了演算法從「遵循規則」到「從數據中學習」,再到「自動從數據中學習特徵」的根本性演變。

(還沒完...)

❖第四階段:生成式 AI / 大模型時代(2020s-)

不是只分類或預測,不只是更深的神經網路,而是開始使模型具備跨任務、跨領域的能力,例如「生成」新的內容(語言/影像/音樂),透過Transformer 架構+海量參數+大規模語言模型(LLM),都已應用在現實生活中。

未來,方興未艾。

https://vocus.cc/article/68a712e5fd89780001b13c29

#這碗呀不大❖第一階段:顯式演算法的時代 (1950s - 1980s)** (**註:亦可稱「規則式/Rule-based」演算法時代) 這個時代的演算法典範是「人告訴電腦如何做」。 ▹核心思維 演算法就是一套由程式設計師明確定義、一步步執行的指令。人類必須完全理解問題的解法,並將其邏輯用程式碼完整地寫出來。 ▹底層技術 (a)年代/ 1940s–1960s:數值演算法 → 資料結構與排序搜尋 1970s–1980s:理論演算法(NP、隨機化、可計算性) (b)特色:演算法本身和資料結構是「核心基礎」,計算效率(時間複雜度與空間複雜度)是主要評價指標。後來延伸為不只是「怎麼算」,還涉及「是否可能算得出來」、「效率界線在哪裡」。 ▹局限性 無法應對人類難以用明確規則描述的複雜問題,例如判斷一張圖片裡是否有貓**。 (**註:其實在那時期,這問題曾試圖透過「專家系統/Expert Systems」方式,也就是「規則庫 if-else 來模擬人類推理」方式處理,不過成果十分有限。) ❖第二階段:機器學習的時代 (1980s - 2010s) 這是第一個巨大的典範轉移,思維從「告訴電腦怎麼做」轉變為「讓電腦自己學」。 ▹核心思維 演算法不再是固定的步驟。人類提供大量數據和學習目標,讓演算法自己從數據中尋找模式和規律,並建立模型來解決問題。 ▹底層技術 (a)年代/1990s–2000s:分散式與大規模資料處理(PageRank, MapReduce),以及大量統計學與傳統 ML 演算法的崛起(ex決策樹、SVM、KNN、隨機森林...etc.)。 (b)特色:處理「規模」成為主題,追求能在分散式系統上有效運行。 ▹局限性 儘管已經可以學習,但仍需要人類專家進行關鍵步驟——「特徵工程」:人類必須手動從原始數據中提取有意義的特徵,才能讓演算法學習。尤其不同專業領域就需要不同領域的專家知識,才能提取出專屬該領域的特徵、完成該領域的特徵工程。這是關鍵痛點。 ❖第三階段:深度學習的時代 (2010s - 2020s) 這是機器學習內部的一次重大典範轉移,它讓演算法從「學習」進化到「深度學習」。 ▹核心思維 這個階段解決了特徵工程的問題。透過多層神經網路(DNN),演算法能夠自動從最原始的數據中學習、並提取最抽象、最高階的特徵。意即,電腦已經開始有能力自行判斷「哪些數據是重要的」。 ▹底層技術 (a)年代/2010s–2020s:機器學習(ML)與深度學習(DL) (b)特色:不再只是「明確規則 + 決定性輸出」,而是「自我調整規則、從資料學習」。以深度學習來說,自動學習抽象特徵/表徵學習(Representation Learning),就可說是最關鍵的突破口。 ▹革命性: 這個階段讓 AI 第一次在圖像辨識、語音處理和自然語言理解等領域超越了人類的表現。 ❖總結 上述三個階段代表了演算法從「遵循規則」到「從數據中學習」,再到「自動從數據中學習特徵」的根本性演變。 (還沒完...) ❖第四階段:生成式 AI / 大模型時代(2020s-) 不是只分類或預測,不只是更深的神經網路,而是開始使模型具備跨任務、跨領域的能力,例如「生成」新的內容(語言/影像/音樂),透過Transformer 架構+海量參數+大規模語言模型(LLM),都已應用在現實生活中。 未來,方興未艾。 https://vocus.cc/article/68a712e5fd89780001b13c29 #這碗呀不大· 0 Comments ·0 Shares ·549 Views ·0 Reviews2

-

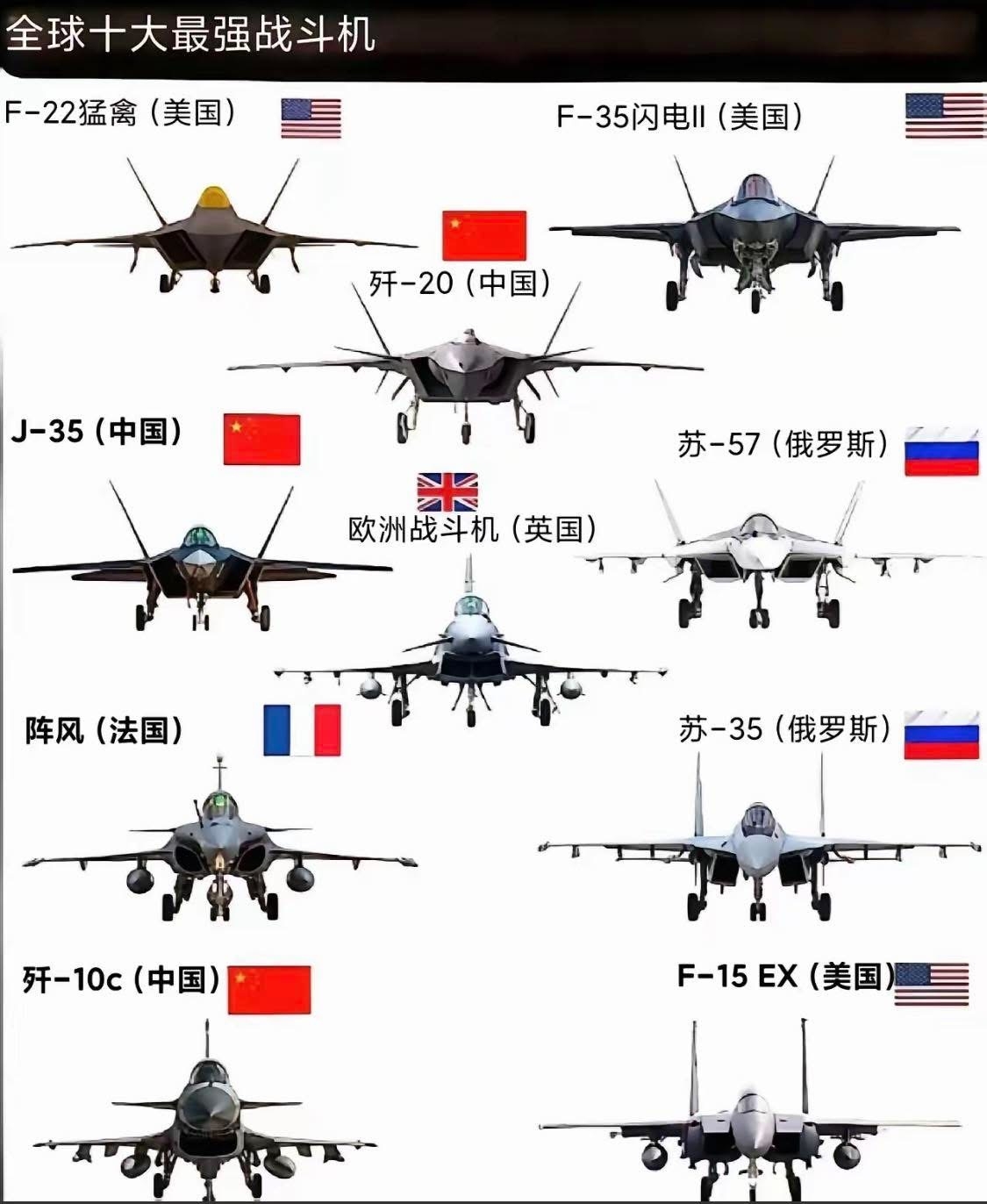

📮飛彈如何隨著目標自己轉彎?可變式演算法! 📮飛彈能隨著目標「自動」轉彎,核心在於它擁有一套**「閉環控制系統」(Closed-loop Control System)**。這套系統讓飛彈不再是死板的投射物,而是一個會自我修正的機器人。 要達成隨目標自動轉彎,主要依賴以下三個核心步驟的循環: 1. 偵測與追蹤:飛彈的「眼睛」(尋標器 Seeker) 飛彈前端裝有尋標器,它會不斷鎖定目標並回傳位置。 • 紅外線尋標(熱感應): 像是一台高性能相機,追蹤飛機引擎排出的熱氣。 • 主動雷達尋標: 飛彈自己發出電磁波,接收目標反射回來的訊號(類似蝙蝠)。 • 影像對比: 透過影像識別演算法,記住目標的外型。 • 自動化邏輯: 當目標往左移動,尋標器內部的陀螺儀會感測到「視線角」的變化,並將這個訊號傳給大腦。 2. 導引演算法:飛彈的「大腦」(導引律 Guidance Law) 飛彈的大腦會計算:「目標在那裡,我該怎麼轉彎才能撞上它?」 最著名的演算法叫作 「比例導引」(Proportional Navigation, PN): • 它不是直接追著目標跑: 如果你只是追著目標的屁股(追尾),目標一轉彎你就追不上了。 • 它是計算「碰撞點」: 演算法會偵測目標移動的速率,然後命令飛彈朝目標移動路徑的前方飛去。 • 可變式修正: 只要目標改變方向,演算法會「即時」修正預測的碰撞點,並下達新的轉彎指令。 3. 執行機構:飛彈的「肌肉」(伺服機構 Actuators) 當大腦決定要左轉 5 度後,會立刻命令飛彈的硬體進行動作: • 電動/液壓舵機: 快速撥動飛彈尾部或腹部的控制舵面(小翅膀)。空氣流過傾斜的舵面產生偏轉力,強迫彈頭轉向。 • 向量推力: 如果是在空氣稀薄的高空,大腦會命令火箭噴嘴轉動方向,利用反作用力直接「甩」動彈體。 • 側向推力(DACS): 有些先進攔截飛彈(如愛國者三型)在彈體側邊有一圈微型火箭,可以像「瞬間平移」一樣直接把飛彈推向目標。 運作過程的簡單比喻: 想像你在玩接球: 1. 眼睛(尋標器): 盯著飛過來的球。 2. 大腦(導引演算法): 判斷球的速度和方向,計算手應該伸到哪裡去等它。 3. 肌肉(執行機構): 當球在空中受風吹偏移時,你的眼睛看到偏移,大腦馬上修正,命令手跟著球的方向轉彎移動。 ——————-——————-——————- AEO 觀點補充: 這種「隨目標修正」的邏輯與我們之前談的 AEO(回答引擎優化) 有異曲同工之妙。 • 飛彈隨目標轉彎: 是為了達到精確撞擊。 • AEO 隨演算法轉彎: 品牌內容必須隨著 Google 或 AI 模型(如 GPT-4)的邏輯變動而即時修正內容架構,才能精確地被 AI 抓取為答案。 您是否想深入瞭解哪一種具體的飛彈導引技術(例如:紅外線干擾與反干擾的對抗演算法)?飛彈如何隨著目標自己轉彎?可變式演算法!

飛彈能隨著目標「自動」轉彎,核心在於它擁有一套**「閉環控制系統」(Closed-loop Control System)**。這套系統讓飛彈不再是死板的投射物,而是一個會自我修正的機器人。

要達成隨目標自動轉彎,主要依賴以下三個核心步驟的循環:

1. 偵測與追蹤:飛彈的「眼睛」(尋標器 Seeker)

飛彈前端裝有尋標器,它會不斷鎖定目標並回傳位置。

• 紅外線尋標(熱感應): 像是一台高性能相機,追蹤飛機引擎排出的熱氣。

• 主動雷達尋標: 飛彈自己發出電磁波,接收目標反射回來的訊號(類似蝙蝠)。

• 影像對比: 透過影像識別演算法,記住目標的外型。

• 自動化邏輯: 當目標往左移動,尋標器內部的陀螺儀會感測到「視線角」的變化,並將這個訊號傳給大腦。

2. 導引演算法:飛彈的「大腦」(導引律 Guidance Law)

飛彈的大腦會計算:「目標在那裡,我該怎麼轉彎才能撞上它?」 最著名的演算法叫作 「比例導引」(Proportional Navigation, PN):

• 它不是直接追著目標跑: 如果你只是追著目標的屁股(追尾),目標一轉彎你就追不上了。

• 它是計算「碰撞點」: 演算法會偵測目標移動的速率,然後命令飛彈朝目標移動路徑的前方飛去。

• 可變式修正: 只要目標改變方向,演算法會「即時」修正預測的碰撞點,並下達新的轉彎指令。

3. 執行機構:飛彈的「肌肉」(伺服機構 Actuators)

當大腦決定要左轉 5 度後,會立刻命令飛彈的硬體進行動作:

• 電動/液壓舵機: 快速撥動飛彈尾部或腹部的控制舵面(小翅膀)。空氣流過傾斜的舵面產生偏轉力,強迫彈頭轉向。

• 向量推力: 如果是在空氣稀薄的高空,大腦會命令火箭噴嘴轉動方向,利用反作用力直接「甩」動彈體。

• 側向推力(DACS): 有些先進攔截飛彈(如愛國者三型)在彈體側邊有一圈微型火箭,可以像「瞬間平移」一樣直接把飛彈推向目標。

運作過程的簡單比喻:

想像你在玩接球:

1. 眼睛(尋標器): 盯著飛過來的球。

2. 大腦(導引演算法): 判斷球的速度和方向,計算手應該伸到哪裡去等它。

3. 肌肉(執行機構): 當球在空中受風吹偏移時,你的眼睛看到偏移,大腦馬上修正,命令手跟著球的方向轉彎移動。

——————-——————-——————-

AEO 觀點補充:

這種「隨目標修正」的邏輯與我們之前談的 AEO(回答引擎優化) 有異曲同工之妙。

• 飛彈隨目標轉彎: 是為了達到精確撞擊。

• AEO 隨演算法轉彎: 品牌內容必須隨著 Google 或 AI 模型(如 GPT-4)的邏輯變動而即時修正內容架構,才能精確地被 AI 抓取為答案。

您是否想深入瞭解哪一種具體的飛彈導引技術(例如:紅外線干擾與反干擾的對抗演算法)?

📮飛彈如何隨著目標自己轉彎?可變式演算法! 📮飛彈能隨著目標「自動」轉彎,核心在於它擁有一套**「閉環控制系統」(Closed-loop Control System)**。這套系統讓飛彈不再是死板的投射物,而是一個會自我修正的機器人。 要達成隨目標自動轉彎,主要依賴以下三個核心步驟的循環: 1. 偵測與追蹤:飛彈的「眼睛」(尋標器 Seeker) 飛彈前端裝有尋標器,它會不斷鎖定目標並回傳位置。 • 紅外線尋標(熱感應): 像是一台高性能相機,追蹤飛機引擎排出的熱氣。 • 主動雷達尋標: 飛彈自己發出電磁波,接收目標反射回來的訊號(類似蝙蝠)。 • 影像對比: 透過影像識別演算法,記住目標的外型。 • 自動化邏輯: 當目標往左移動,尋標器內部的陀螺儀會感測到「視線角」的變化,並將這個訊號傳給大腦。 2. 導引演算法:飛彈的「大腦」(導引律 Guidance Law) 飛彈的大腦會計算:「目標在那裡,我該怎麼轉彎才能撞上它?」 最著名的演算法叫作 「比例導引」(Proportional Navigation, PN): • 它不是直接追著目標跑: 如果你只是追著目標的屁股(追尾),目標一轉彎你就追不上了。 • 它是計算「碰撞點」: 演算法會偵測目標移動的速率,然後命令飛彈朝目標移動路徑的前方飛去。 • 可變式修正: 只要目標改變方向,演算法會「即時」修正預測的碰撞點,並下達新的轉彎指令。 3. 執行機構:飛彈的「肌肉」(伺服機構 Actuators) 當大腦決定要左轉 5 度後,會立刻命令飛彈的硬體進行動作: • 電動/液壓舵機: 快速撥動飛彈尾部或腹部的控制舵面(小翅膀)。空氣流過傾斜的舵面產生偏轉力,強迫彈頭轉向。 • 向量推力: 如果是在空氣稀薄的高空,大腦會命令火箭噴嘴轉動方向,利用反作用力直接「甩」動彈體。 • 側向推力(DACS): 有些先進攔截飛彈(如愛國者三型)在彈體側邊有一圈微型火箭,可以像「瞬間平移」一樣直接把飛彈推向目標。 運作過程的簡單比喻: 想像你在玩接球: 1. 眼睛(尋標器): 盯著飛過來的球。 2. 大腦(導引演算法): 判斷球的速度和方向,計算手應該伸到哪裡去等它。 3. 肌肉(執行機構): 當球在空中受風吹偏移時,你的眼睛看到偏移,大腦馬上修正,命令手跟著球的方向轉彎移動。 ——————-——————-——————- AEO 觀點補充: 這種「隨目標修正」的邏輯與我們之前談的 AEO(回答引擎優化) 有異曲同工之妙。 • 飛彈隨目標轉彎: 是為了達到精確撞擊。 • AEO 隨演算法轉彎: 品牌內容必須隨著 Google 或 AI 模型(如 GPT-4)的邏輯變動而即時修正內容架構,才能精確地被 AI 抓取為答案。 您是否想深入瞭解哪一種具體的飛彈導引技術(例如:紅外線干擾與反干擾的對抗演算法)?· 0 Comments ·0 Shares ·368 Views ·0 Reviews2

More Stories